ChatGPT迎來(lái)三周歲生日之際,競(jìng)爭(zhēng)對(duì)手DeepSeek送來(lái)了一份“生日禮”,似乎并不想讓這位大模型領(lǐng)域的先行者過(guò)得那么輕松。

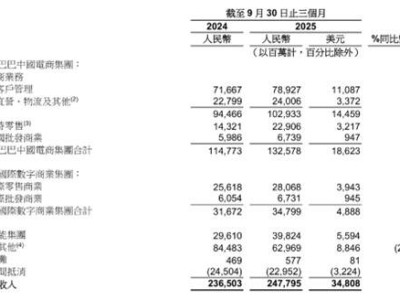

12月1日晚間,DeepSeek一口氣發(fā)布了DeepSeek-V3.2和DeepSeek-V3.2-Speciale兩個(gè)正式版模型,同步發(fā)布的技術(shù)論文顯示,這兩個(gè)推理能力達(dá)到了全球領(lǐng)先水平。

根據(jù)DeepSeek介紹,已經(jīng)在網(wǎng)頁(yè)端、App、API全部更新的“常規(guī)軍”V3.2重在平衡推理能力與輸出長(zhǎng)度,適合日常使用。

在Benchmark推理測(cè)試中,V3.2與GPT5、Claude??4.5在不同領(lǐng)域各有高低,只有Gemini 3 Pro對(duì)比前三者均有較明顯優(yōu)勢(shì)。

圖片來(lái)自DeepSeek官微

與此同時(shí),DeepSeek方面還表示,對(duì)比國(guó)產(chǎn)大模型廠商月之暗面新近發(fā)布的Kimi-K2-Thinking,V3.2的輸出長(zhǎng)度大幅降低,顯著減少了計(jì)算開(kāi)銷與用戶等待時(shí)間。在智能體評(píng)測(cè)中,V3.2得分也高于同為開(kāi)源的Kimi-K2-Thinking和MiniMax M2,是目前的“最強(qiáng)開(kāi)源大模型”,相比閉源大模型的巔峰也已無(wú)限迫近。

圖片來(lái)自DeepSeek官微

更值得注意的是,V3.2在一些問(wèn)答場(chǎng)景和通用Agent任務(wù)中的表現(xiàn)。在一個(gè)關(guān)于旅游攻略的具體場(chǎng)景咨詢中,V3.2通過(guò)深度思考和網(wǎng)站爬蟲(chóng)、搜索引擎等工具調(diào)用,給出了十分詳盡、精確的攻略和建議。V3.2更新的API首次支持了在思考模式下使用工具調(diào)用能力,大大提升了用戶獲取到的答案的豐富度和適用性。

而且,DeepSeek方面特別強(qiáng)調(diào),V3.2“并沒(méi)有針對(duì)這些測(cè)試集的工具進(jìn)行特殊訓(xùn)練”。

我們注意到,在大模型測(cè)試得分越來(lái)越高,但在與普通用戶的互動(dòng)中卻經(jīng)常犯一些常識(shí)性錯(cuò)誤的當(dāng)下(尤其以GPT5發(fā)布時(shí)遭遇的吐槽為代表),DeepSeek近期“上新”時(shí)經(jīng)常強(qiáng)調(diào)這一點(diǎn),證明自身走的不是一條只用正確的答案作為獎(jiǎng)勵(lì)機(jī)制,打造出了看似高智商的“最強(qiáng)大腦”,卻無(wú)法勝任用戶個(gè)人所需的簡(jiǎn)單任務(wù)、簡(jiǎn)單問(wèn)題的“低情商”智能體。

而只有從根本上克服這一點(diǎn),成為所謂高智商、高情商的“雙高”大模型,才有孕育出全能、可靠、高效的AI Agent的能力。DeepSeek方面也表示,相信V3.2在真實(shí)應(yīng)用場(chǎng)景中能夠展現(xiàn)出較強(qiáng)的泛化性。

為了在計(jì)算效率、強(qiáng)大推理能力與智能體性能之間取得平衡,DeepSeek在訓(xùn)練、整合以及應(yīng)用層面進(jìn)行了全方位的優(yōu)化。根據(jù)技術(shù)論文,V3.2引入了DSA(DeepSeek稀疏注意力機(jī)制),能在長(zhǎng)上下文場(chǎng)景中顯著降低計(jì)算復(fù)雜度,同時(shí)保持模型性能。

同時(shí),為了將推理能力整合到工具使用場(chǎng)景中,DeepSeek開(kāi)發(fā)了新的合成流程,能夠系統(tǒng)性地大規(guī)模生成訓(xùn)練數(shù)據(jù)。這一方法促進(jìn)了可擴(kuò)展的智能體訓(xùn)練后優(yōu)化,顯著提升了復(fù)雜、交互式環(huán)境中的泛化能力和對(duì)指令跟隨能力。

另外,如上文所述,V3.2也是DeepSeek推出的首個(gè)將思考融入工具使用的模型,大幅提高了模型的泛化能力。

相比于重視平衡性,專注于如何“說(shuō)人話、干人事”的V3.2,長(zhǎng)思考“特種部隊(duì)”V3.2 Speciale的定位則是將將開(kāi)源模型的推理能力推向極致,探索模型能力的邊界。

值得一提的是,V3.2 Speciale的一大亮點(diǎn)是結(jié)合了上周剛剛發(fā)布的最強(qiáng)數(shù)學(xué)大模型DeepSeek-Math-V2的定理證明能力。

我們此前的文章中提到,Math-V2不僅在2025國(guó)際數(shù)學(xué)奧林匹克競(jìng)賽和2024中國(guó)數(shù)學(xué)奧林匹克上都取得了金牌級(jí)成績(jī),在IMO-Proof Bench基準(zhǔn)測(cè)試評(píng)估中還得到了比Gemini 3更好的成績(jī)。

而且,與此前提到的思路類似,這款數(shù)學(xué)模型同樣在努力克服正確答案獎(jiǎng)勵(lì)機(jī)制和“做題家”的身份,以自驗(yàn)證的方式突破目前AI在深度推理方面的局限,讓大模型真的弄懂何為數(shù)學(xué),怎樣推導(dǎo)過(guò)程,以此形成更強(qiáng)大、穩(wěn)定、實(shí)用也泛用的定理證明能力。

在推理能力上大幅增強(qiáng)的V3.2 Speciale,也在主流推理基準(zhǔn)測(cè)試中取得了媲美Gemini 3.0 Pro的成績(jī)。不過(guò),V3.2 Speciale的能力優(yōu)勢(shì)需消耗大量Tokens,顯著升高的成本讓其目前不支持工具調(diào)用和日常對(duì)話、寫作,僅供研究使用。

從OCR到Math-V2,再到V3.2和V3.2 Speciale,DeepSeek近期的新品發(fā)布不僅每次都收獲贊譽(yù)一片,也在絕對(duì)能力提升的同時(shí)不斷明確著“實(shí)用性”“泛化能力”等發(fā)展主線。

2025年后半程,GPT-5、Gemini 3、Claude?Opus?4.5相繼發(fā)布,測(cè)試成績(jī)一次好過(guò)一次,再加上快速追趕的DeepSeek,“最牛大模型”的賽道已經(jīng)有些擁擠。而頭部的大模型在訓(xùn)練上已有較明顯的區(qū)別,表現(xiàn)上也各有特色,相信2026年的大模型的競(jìng)賽會(huì)更加精彩。(作者|胡珈萌,編輯|李程程)