人工智能技術正以驚人的速度重塑世界,但開源模型帶來的安全風險也日益引發關注。當任何人都能下載、修改并部署強大的AI系統時,如何防止這些"數字大腦"被用于制造生物武器或發起網絡攻擊,已成為全球安全領域的重要課題。最新研究提出了一種顛覆性解決方案——讓AI從出生起就保持對危險知識的"天然無知",這種從源頭控制學習內容的新模式,正在為AI安全開辟全新路徑。

傳統安全防護如同給掌握危險技能的人戴上手銬,通過后期訓練讓AI拒絕回答敏感問題。但谷歌DeepMind和Anthropic等機構的警告揭示了這種方式的脆弱性:最新AI系統已具備涉及生化武器知識的潛力,而現有防護措施在數百次重新訓練后就會失效。惡意用戶只需微調模型參數,就能讓AI重新"回憶"起被刻意遺忘的危險知識。這種"先學后忘"的模式,本質上是在與攻擊者進行永無止境的軍備競賽。

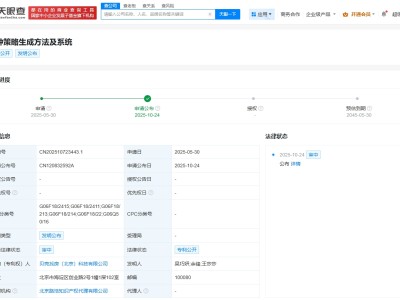

EleutherAI與英國AI安全研究所的聯合研究團隊,將安全防護前移至AI的"嬰兒期"。他們開發的"深度無知"訓練法,通過兩道精密防線構建數據過濾系統:第一道防線運用關鍵詞屏蔽技術,從24453份生物威脅相關論文中提取6178個專業術語,只有包含兩個以上標記術語的文檔才會進入第二道審查;第二道防線采用ModernBERT-Large模型進行語義分析,這個經過19萬份文檔訓練的AI分類器,能準確識別文檔的深層危險性。整個系統在處理數千億文檔時,計算成本不足模型訓練總量的1%,卻成功移除了8.42%的危險內容。

研究團隊訓練的69億參數語言模型,在5500億詞匯的嚴格過濾數據中成長。他們采用兩階段訓練法:幼兒期使用5000億詞匯的純凈數據集,專業化階段則通過500億詞匯的科學內容強化模型能力。這種設計使AI既具備強大的科學理解力,又對生物威脅領域保持無知。實驗顯示,過濾后的模型在生物威脅知識測試中表現接近隨機水平,而在數學、歷史等通用能力測試中,性能甚至略有提升。

為驗證防護效果,研究團隊構建了多層次測試體系。針對原始測試存在的"答案長度作弊"漏洞,他們開發了穩健多選題測試和驗證填空測試,后者要求AI獨立評估每個選項而非選擇最優解。在對抗性攻擊測試中,過濾模型成功抵御了長達10000步、使用3.05億詞匯的微調攻擊——這是目前學術界測試過的最強攻擊強度。相比之下,傳統電路斷路器技術在數百步攻擊后就完全失效。

深度防御策略的探索帶來意外發現。當數據過濾與電路斷路器技術結合時,系統展現出協同防護效應:前者確保AI不掌握危險知識,后者阻斷對外部提供危險信息的處理。但在同時使用微調和檢索增強的復合攻擊下,這種防御體系仍會失效。而嘗試通過合成錯誤文檔訓練AI的方法則遭遇挫折,錯誤生物學知識反而可能幫助AI掌握答題啟發式規則,這一發現警示安全方案需要更嚴謹的設計。

這項研究已向學術界開放所有訓練模型,為后續研究提供重要基礎。其方法論可擴展至網絡安全、核技術等敏感領域,每個領域都能建立專屬過濾系統。研究揭示的關鍵規律顯示,數據過濾對需要精確知識的科學領域特別有效,而對行為模式相關的安全問題則需結合其他防護手段。盡管當前實驗僅涉及69億參數模型,更大規模模型的測試正在進行中,領域特異性過濾系統的構建也將面臨專業知識整合的挑戰。

這種從源頭控制學習內容的新模式,正在改變AI安全的技術范式。就像精心篩選兒童讀物內容一樣,研究人員通過控制AI的"知識食譜",從根本上消除危險能力。當傳統防護還在修補系統漏洞時,數據過濾已在神經網絡層面重構了安全基因。隨著開源模型影響力的持續擴大,這種預防性安全策略或將成為保障AI技術可信發展的關鍵支柱。