斯坦福大學等多家頂尖機構的研究人員聯合開展了一項突破性研究,構建了一個全新的AI能力評測框架——UQ評測體系。該研究已通過學術平臺發布,論文編號為arXiv:2508.17580v1,研究團隊成員來自斯坦福大學、華盛頓大學、北卡羅來納大學及Contextual AI等機構。

傳統AI評測常被比喻為讓考生反復練習歷年高考真題,盡管能檢驗基礎能力,但模型很快就能在固定題型中取得高分,形成“應試化”發展。更關鍵的是,這類測試題往往脫離實際應用場景,難以反映模型解決真實問題的潛力。研究團隊提出創新思路:為何不讓AI直接挑戰人類尚未攻克的難題?這如同要求圍棋AI破解千年未解的殘局,或數學AI證明懸而未決的猜想。

新評測體系的核心優勢在于其雙重特性:問題難度足夠高,確保不會短期內被AI突破;問題均源自現實需求,解決后能產生實際價值。該體系由三個關鍵模塊構成:包含500個真實未解問題的數據集、基于AI的初步驗證系統,以及開放的人類專家驗證平臺。

數據集構建過程堪稱知識考古。研究人員從Stack Exchange網絡(涵蓋80余個專業領域的問答社區)的300萬個未答問題中篩選。初篩階段通過規則過濾,保留至少兩年歷史、獲得足夠關注且無任何解答的問題,將候選范圍縮小至3.4萬個。第二階段采用雙AI協作模式,一個模型生成答案,另一個評估答案質量,進一步篩選出7685個問題。最終由博士級專家人工審核,結合AI模型的嘗試性解答,確定500個高質量難題,其中25個“鉆石級”問題因獲得超高關注度(瀏覽量超2000次、贊同票超75個)被特別標注。

問題領域分布廣泛,數學與數學物理占據主導,包含專業數學家都難以證明的命題;理論計算機科學貢獻了算法復雜性問題;甚至出現科幻愛好者尋找特定書籍、歷史學家考證歷史細節等跨界難題。這種多樣性確保了評測的全面性。

在答案驗證環節,研究團隊發現AI更擅長評估而非生成答案,據此開發了多層次驗證系統。底層檢驗包含正確性核查、事實邏輯檢查和循環一致性驗證;中層采用重復采樣和迭代反思機制;高層整合多數投票、一致投票和流水線驗證策略。實驗表明,三階段流水線驗證使準確率從30%提升至80%,但召回率有所下降。系統還發現,同源AI模型在評估時存在“自戀”傾向,復合驗證策略有效緩解了這種偏見。

盡管AI驗證器表現突出,但其局限性依然明顯:最佳系統精確度僅40%,意味著60%的通過答案可能錯誤;不同驗證器的排名結果差異顯著,提示不能完全依賴自動化評估。因此,研究團隊構建了開放驗證平臺,邀請全球專家參與最終評判。

該平臺設計強調透明與協作,每個問題頁面展示詳細內容、AI答案、驗證結果及推理過程。模型開發者需提交完整提示詞以確保可復現性,人類評審者則進行專業打分并提供評判依據。平臺支持額外AI評審提交,實時統計解決進度、驗證通過率等數據,并建立基于解決問題數量的排行榜。為激勵參與,平臺提供公開署名、教育價值等回報,原問題提出者也可直接參與驗證。

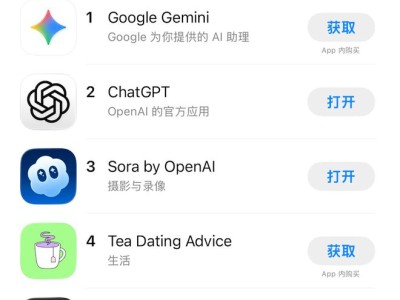

在實戰測試中,OpenAI的o3-PRO、Google的Gemini 2.5 Pro、Anthropic的Claude等頂尖模型接受挑戰。o3-PRO在500個問題中僅有75個答案通過AI驗證(通過率15%),經人類專家確認后,僅10個答案完全正確,其中6個來自數學領域。早期測試中,幾乎所有模型都未能產生有效解答,o3-PRO的4個正確解答成為重要突破。失敗案例顯示,AI常出現引用虛構文獻和邏輯細微錯誤等問題。在25個“鉆石級”問題中,雖4個答案通過AI驗證,但均未通過人類專家確認。

研究引發了對AI發展方向的深入思考。傳統評測如同練習冊習題,難以評估解決復雜問題的能力;新方法則像真實科研項目,更能檢驗創新思維。AI驗證強于生成能力的發現,提示“評委型AI”可能比“創作型AI”更具應用前景。動態更新機制確保評測始終處于技術前沿,而社區驅動模式則推動了科學研究的民主化。

對于公眾參與,UQ平臺已完全開放。訪問者可在uq.stanford.edu查看問題和AI答案,具備專業知識者可注冊成為驗證者,依據平臺提供的評判標準和推理過程進行評估。這種開放模式不僅提高了驗證質量,也讓更多人參與到前沿科學討論中。